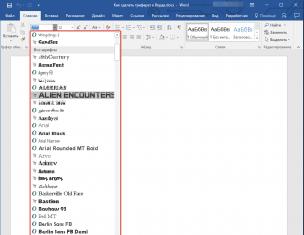

Нейрон является составной частью нейронной сети. На рис. 1 2 показана его структура Он состоит из элементов трех типов: умножителей (синапсов), сумматора и нелинейного преобразователя. Синапсы осуществляют связь между нейронами, умножают входной сигнал на число, характеризующее силу связи, (вес синапса). Сумматор выполняет сложение сигналов, поступающих по синаптическим связям от других нейронов, и внешних входных сигналов. Нелинейный преобразователь реализует нелинейную функцию одного аргумента - выхода сумматора. Эта функция называется функцией активации или передаточной функцией

Рис. 1.2 Структура искусственного нейрона

нейрона. Нейрон в целом реализует скалярную функцию векторного аргумента. Математическая модель нейрона:

где - вес (weight) синапса, - значение смещения (bias), s - результат суммирования (sum); х - компонент входного вектора (входной сигнал), выходной сигнал нейрона; - число входов нейрона; - нелинейное преобразование (функция активации).

В общем случае входной сигнал, весовые коэффициенты и смещение могут принимать действительные значения, а во многих практических задачах - лишь некоторые фиксированные значения. Выход определяется видом функции активации и может быть как действительным, так и целым.

Синаптические связи с положительными весами называют возбуждающими, с отрицательными весами - тормозящими.

Описанный вычислительный элемент можно считать упрощенной математической моделью биологических нейронов. Чтобы подчеркнуть различие нейронов биологических и искусственных, вторые иногда называют нейроноподобными элементами или формальными нейронами.

На входной сигнал нелинейный преобразователь отвечает выходным сигналом который представляет собой выход у

нейрона Примеры активационных функций представлены в табл. 1.1 и на рис. 1.3

Таблица 1.1 (см. скан) Функции активации нейронов

Одной из наиболее распространенных является нелинейная функция активации с насыщением, так называемая логистическая функция или сигмоид (функция S-образного вида)

![]()

При уменьшении а сигмоид становится более пологим, в пределе при вырождаясь в горизонтальную линию на уровне 0,5, при увеличении а сигмоид приближается к виду функции

Рис. 1.3 Примеры активационных функций а - функция единичного скачка, б - линейный порог (гистерезис), в - сигмоид (логистическая функция), г - сигмоид (гиперболический тангенс)

единичного скачка с порогом Из выражения для сигмоида очевидно, что выходное значение нейрона лежит в диапазоне Одно из ценных свойств сигмоидальной функции - простое выражение для ее производной, применение которой будет рассмотрено в дальнейшем

![]()

Следует отметить, что сигмоидальная функция дифференцируема на всей оси абсцисс, что используется в некоторых алгоритмах обучения Кроме того, она обладает свойством усиливать слабые сигналы лучше, чем большие, и предотвращает насыщение от больших сигналов, так как они соответствуют областям аргументов, где сигмоид имеет пологий наклон

Искусственный нейрон

Схема искусственного нейрона

1.Нейроны, выходные сигналы которых поступают на вход данному

2.Сумматор входных сигналов

3.Вычислитель передаточной функции

4.Нейроны, на входы которых подаётся выходной сигнал данного

5. - веса

входных сигналов

Иску́сственный нейро́н (Математический нейрон Маккалока - Питтса , Формальный нейрон ) - узел искусственной нейронной сети , являющийся упрощённой моделью естественного нейрона . Математически, искусственный нейрон обычно представляют как некоторую нелинейную функцию от единственного аргумента - линейной комбинации всех входных сигналов. Данную функцию называют функцией активации или функцией срабатывания , передаточной функцией . Полученный результат посылается на единственный выход. Такие искусственные нейроны объединяют в сети - соединяют выходы одних нейронов с входами других. Искусственные нейроны и сети являются основными элементами идеального нейрокомпьютера .

Биологический прототип

Биологический нейрон состоит из тела диаметром от 3 до 100 мкм, содержащего ядро (с большим количеством ядерных пор) и другие органеллы (в том числе сильно развитый шероховатый ЭПР с активными рибосомами , аппарат Гольджи), и отростков. Выделяют два вида отростков. Аксон - обычно длинный отросток, приспособленный для проведения возбуждения от тела нейрона. Дендриты - как правило, короткие и сильно разветвлённые отростки, служащие главным местом образования влияющих на нейрон возбуждающих и тормозных синапсов (разные нейроны имеют различное соотношение длины аксона и дендритов). Нейрон может иметь несколько дендритов и обычно только один аксон. Один нейрон может иметь связи с 20-ю тысячами других нейронов. Кора головного мозга человека содержит 10-20 миллиардов нейронов.

История развития

При этом возможен сдвиг функции по обеим осям (как изображено на рисунке).

Недостатками шаговой и полулинейной активационных функций относительно линейной можно назвать то, что они не являются дифференцируемыми на всей числовой оси, а значит не могут быть использованы при обучении по некоторым алгоритмам.

Пороговая функция активации

Пороговая передаточная функция

Гиперболический тангенс

Здесь - расстояние между центром и вектором входных сигналов . Скалярный параметр определяет скорость спадания функции при удалении вектора от центра и называется шириной окна , параметр определяет сдвиг активационной функции по оси абсцисс. Сети с нейронами, использующими такие функции, называются RBF-сетями. В качестве расстояния между векторами могут быть использованы различные метрики , обычно используется евклидово расстояние:

Здесь - j-я компонента вектора, поданного на вход нейрона, а - j-я компонента вектора, определяющего положение центра передаточной функции. Соответственно, сети с такими нейронами называются вероятностными и регрессионными .

В реальных сетях активационная функция этих нейронов может отражать распределение вероятности какой-либо случайной величины , либо обозначать какие-либо эвристические зависимости между величинами.

Другие функции передачи

Перечисленные выше функции составляют лишь часть от множества передаточных функций, используемых на данный момент. В число других передаточных функций входят такие как :

Стохастический нейрон

Выше описана модель детерминистического искусственного нейрона, то есть состояние на выходе нейрона однозначно определено результатом работы сумматора входных сигналов. Рассматривают также стохастические нейроны, где переключение нейрона происходит с вероятностью, зависящей от индуцированного локального поля, то есть передаточная функция определена как

где распределение вероятности обычно имеет вид сигмоида

a нормировочная константа вводится для условия нормализации распределения вероятности . Таким образом, нейрон активируется с вероятностью P(u). Параметр T - аналог температуры (но не температуры нейрона!) и определяет беспорядок в нейронной сети. Если Т устремить к 0, стохастический нейрон перейдет в обычный нейрон с передаточной функцией Хевисайда (пороговой функцией).

Моделирование формальных логических функций

Нейрон с пороговой передаточной функцией может моделировать различные логические функции. Изображения иллюстрируют, каким образом можно, задав веса входных сигналов и порог чувствительности, заставить нейрон выполнять конъюнкцию (логическое «И») и дизъюнкцию (логическое «ИЛИ») над входными сигналами, а также логическое отрицание входного сигнала . Этих трех операций достаточно, чтобы смоделировать абсолютно любую логическую функцию любого числа аргументов.

Примечания

Литература

- Терехов В.А., Ефимов Д.В., Тюкин И.Ю. Нейросетевые системы управления. - 1-е. - Высшая школа, 2002. - С. 184. - ISBN 5-06-004094-1

- Круглов В. В., Борисов В. В.

Искусственный нейрон

Структура искусственного нейрона

Искусственный нейрон является структурной единицей искусственной нейронной сети и представляет собой аналог биологического нейрона.

С математической точки зрения искусственный нейрон — это сумматор всех входящих сигналов, применяющий к полученной взвешенной сумме некоторую простую, в общем случае, нелинейную функцию, непрерывную на всей области определения. Обычно, данная функция монотонно возрастает. Полученный результат посылается на единственный выход.

Искусственные нейроны (в дальнейшем нейроны) объединяются между собой определенным образом, образуя искусственную нейронную сеть. Каждый нейрон характеризуется своим текущим состоянием по аналогии с нервными клетками головного мозга, которые могут быть возбуждены или заторможены. Он обладает группой синапсов – однонаправленных входных связей, соединенных с выходами других нейронов, а также имеет аксон – выходную связь данного нейрона, с которой сигнал поступает на синапсы следующих нейронов.

Каждый синапс характеризуется величиной синаптической связи или ее весом w i , который является эквивалентом электрической проводимости биологических нейронов.

Текущее состояние нейрона определяется, как взвешенная сумма его входов:

(1)

,

где w 0 — коэффициент смещения нейрона (вес единичного входа)

Выход нейрона есть функция его состояния:

y = f(s)

Нелинейная функция f называется активационной и может иметь различный вид, как показано на рисунке ниже. Одной из наиболее распространенных является нелинейная функция с насыщением, так называемая логистическая функция или сигмоид (т.е. функция S -образного вида):

(2)

,

При уменьшении α сигмоид становится более пологим, в пределе при α=0 вырождаясь в горизонтальную линию на уровне 0.5, при увеличении α сигмоид приближается по внешнему виду к функции единичного скачка с порогом T в точке x =0. Из выражения для сигмоида очевидно, что выходное значение нейрона лежит в диапазоне . Следует отметить, что сигмоидная функция дифференцируема на всей оси абсцисс, что используется в некоторых . Кроме того, она обладает свойством усиливать слабые сигналы лучше, чем большие, и предотвращает насыщение от больших сигналов, так как они соответствуют областям аргументов, где сигмоид имеет пологий наклон.

а) функция единичного скачка; б) линейный порог (гистерезис);

в) сигмоид — гиперболический тангенс; г) сигмоид — формула

Нейрокомпьютеров- вычисл. системы 6-го поколения, кот. состоят из большого числа параллельно работающих простых вычис.элементов (нейронов). Эл-ы связаны между собой, образуя нейронную сеть. Они выполняют единообразные вычисл. действия и не требуют внешнего управления. Большое число параллельно работающих вычисл.эл-ов обеспечивают высокое быстродействие.

В наст. время разработка нейрокомпьютеров ведется в большинстве промышленно развитых стран.

Нейрокомпьютеры позволяют с высокой эффективностью решать целый ряд интеллектуальных задач. Это задачи:

распознавания образов

адаптивного управления

прогнозирования

диагностики и т.д.

Нейрокомпьютеры отличаются от ЭВМ предыдущих поколений не просто большими возможностями. Принципиально меняется способ использования машины. Место прогр-я занимает обучение, нейрокомпьютер учится решать задачи.

Обучение - корректировка весов связей, в результате которой каждое входное воздействие приводит к формированию соответствующего выходного сигнала. После обучения сеть может применять полученные навыки к новым входным сигналам. При переходе от программирования к обучению повышается эффективность решения интеллектуальных задач.

Нейрокомпьютер Synapse (Siemens);

Нейр-р «Силиконовый мозг» (США, «Электронный мозг» для обработки аэрокосмических изображений).

Понятие искусст. нейрона. Формальный нейрон. Структура. Матем.модель нейрона. Принцип работы.

Иску́сственный нейро́н (Математический нейрон Маккалока - Питтса, Формальный нейрон ) - узел искусственной нейронной сети, являющийся упрощённой моделью естественного нейрона. Математически, искусственный нейрон обычно представляют, как некоторую нелинейную функцию от единственного аргумента - линейной комбинации всех входных сигналов. Данную функцию называют функцией активации или функцией срабатывания , передаточной функцией . Полученный результат посылается на единственный выход. Такие искусственные нейроны объединяют в сети - соединяют выходы одних нейронов с входами других. Искусственные нейроны и сети являются основными элементами идеального нейрокомпьютера.

Формальный нейрон - в нейронных сетях - процессорный элемент, преобразователь данных, получающий входные данные и преобр-й их в соответс. с заданной функцией и параметрами. Форм. нейрон работает с дискретным временем.

Схема искусственного нейрона

1.Нейроны, выходные сигналы которых поступают на вход данному 2.Сумматор входных сигналов 3.Вычислитель передаточной функции 4.Нейроны, на входы которых подаётся выходной сигнал данного 5.-веса входных сигналов

Математически нейрон предст. собой взвешенный сумматор, единств.выход которого опр-ся через его входы и матрицу весов следующим образом:

Где

![]()

Здесь и- соответственно сигналы на входах нейрона и веса входов, функция u называется индуцированным локальным полем, а f(u) - передаточной функцией. Возможные значения сигналов на входах нейрона считают заданными в интервале. Они могут быть либо дискретными (0 или 1), либо аналоговыми. Дополнительный входи соответствующий ему весиспользуются дляинициализации нейрона. Под инициализацией подразумевается смещение активационной функции нейрона по горизонтальной оси, то есть формирование порога чувствительности нейрона. Кроме того, иногда к выходу нейрона специально добавляют некую случайную величину, называемую сдвигом. Сдвиг можно рассматривать как сигнал на дополнительном, всегда нагруженном, синапсе.

Активационная функция нейрона. Виды функций.

Активационная функция нейрона определяет нелинейное преобразование, осуществляемое нейроном.

Существует множество видов активационных функций, но более всего распространены следующие четыре:

1. Пороговая функция. На рис. 7.2, а приведен ее график.

.

(7.5)

.

(7.5)

Первая из введенных активационных функций, она была описана в работе Мак-Каллока и Питтса. В честь этого модель нейрона с пороговой активационной функцией называется моделью Мак-Каллока-Питтса.

2. Кусочно-линейная функция. Она изображена на рис. 7.2, б и описывается следующей зависимостью:

.

(7.6)

.

(7.6)

В данном случае a =1, и коэффициент наклона линейного участка выбран единичным, а вся функция может интерпретироваться как аппроксимация нелинейного усилителя. При бесконечно большом коэффициенте наклона линейного участка функция вырождается в пороговую.

В большинстве типов искусственных нейронных сетей используются нейроны с линейной активационной функцией , представляющей собой частный случай (7.6) с неограниченным линейным участком.

Рис. 7.2. Типы активационных функций а), г) пороговая; б) линейная; в) сигмоидальная; д) тангенциальная; е) радиально-базисная активационные функции

Понятие искусственной нейронной сети.

Иску́сственная нейро́нная се́ть (ИНС) - математическая модель, а также её программная или аппаратная реализация, построенная по принципу организации и функционирования биологических нейронных сетей - сетей нервных клеток живого организма. Это понятие возникло при изучении процессов, протекающих в мозге, и при попытке смоделировать эти процессы. Первой такой попыткой были нейронные сети У. Маккалока и У. Питтса. После разработки алгоритмов обучения получаемые модели стали использовать в практических целях: в задачах прогнозирования, для распознавания образов, в задачах управления и др.

ИНС представляют собой систему соединённых и взаимодействующих между собой простых процессоров (искусственных нейронов). Такие процессоры обычно довольно просты (особенно в сравнении с процессорами, используемыми в персональных компьютерах). Каждый процессор подобной сети имеет дело только с сигналами, которые он периодически получает, и сигналами, которые он периодически посылает другим процессорам. И, тем не менее, будучи соединёнными в достаточно большую сеть с управляемым взаимодействием, такие локально простые процессоры вместе способны выполнять довольно сложные задачи.

С точки зрения машинного обучения, нейронная сеть представляет собой частный случай методов распознавания образов, дискриминантного анализа, методов кластеризации и т. п. С математической точки зрения, обучение нейронных сетей - это многопараметрическая задача нелинейной оптимизации. С точки зрения кибернетики, нейронная сеть используется в задачах адаптивного управления и как алгоритмы для робототехники. С точки зрения развития вычислительной техники и программирования, нейронная сеть - способ решения проблемы эффективного параллелизма . А с точки зрения искусственного интеллекта, ИНС является основой философского течения коннективизма и основным направлением в структурном подходе по изучению возможности построения (моделирования) естественного интеллекта с помощью компьютерных алгоритмов.

Нейронные сети не программируются в привычном смысле этого слова, они обучаются . Возможность обучения - одно из главных преимуществ нейронных сетей перед традиционными алгоритмами. Технически обучение заключается в нахождении коэффициентов связей между нейронами. В процессе обучения нейронная сеть способна выявлять сложные зависимости между входными данными и выходными, а также выполнять обобщение. Это значит, что в случае успешного обучения сеть сможет вернуть верный результат на основании данных, которые отсутствовали в обучающей выборке, а также неполных и/или «зашумленных», частично искаженных данных.

Схема простой нейросети. Зел. цветом обозн. входные нейроны, гол.- скрытые нейроны, жёлтым - выходной нейрон.

Основные характеристики нейронных сетей.

Некоторые свойства нейронных сетей.

1. Обучение

Искусственные нейронные сети могут менять свое поведение в зависимости от внешней среды. Этот фактор в большей степени, чем любой другой, ответствен за тот интерес, который они вызывают. После предъявления входных сигналов (возможно, вместе с требуемыми выходами) они самонастраиваются, чтобы обеспечивать требуемую реакцию. Было разработано множество обучающих алгоритмов, каждый со своими сильными и слабыми сторонами. Все еще существуют проблемы относительно того, чему сеть может обучиться и как обучение должно проводиться.

2. Обобщение

Отклик сети после обучения может быть до некоторой степени нечувствителен к небольшим изменениям входных сигналов. Эта внутренне присущая способность видеть образ сквозь шум и искажения жизненно важна для распознавания образов в реальном мире. Она позволяет преодолеть требование строгой точности, предъявляемое обычным компьютером, и открывает путь к системе, которая может иметь дело с тем несовершенным миром, в котором мы живем. Важно отметить, что искусственная нейронная сеть делает обобщения автоматически благодаря своей структуре, а не с помощью использования «человеческого интеллекта» в форме специально написанных компьютерных программ.

3. Абстрагирование

Некоторые из искусственных нейронных сетей обладают способностью извлекать сущность из входных сигналов. Например, сеть может быть обучена на последовательности искаженных версий буквы «А». После соответствующего обучения предъявление такого искаженного примера приведет к тому, что сеть породит букву совершенной формы (в данном случае букву «А»). В некотором смысле она научится порождать то, что никогда не видела. Способность извлекать идеальные прототипы является у людей весьма ценным качеством.

4. Применимость

Искусственные нейронные сети не являются панацеей. Они, очевидно, не годятся для выполнения таких задач, как начисление заработной платы, однако они незаменимы в большом классе других задач, с которыми плохо или вообще не справляются обычные вычислительные системы.

Задачи, решаемые нейронными сетями.

НС хорошо подходят для распознавания образов и решения задач классификации, оптимизации и прогнозирования. Ниже приведен перечень возможных промышленных применений нейронных сетей, на базе которых либо уже созданы коммерческие продукты, либо реализованы демонстрационные прототипы.

Банки и страховые компании:

автоматическое считывание чеков и финансовых документов;

проверка достоверности подписей;

оценка риска для займов;

прогнозирование изменений экономических показателей.

Административное обслуживание:

автоматическое считывание документов;

автоматическое распознавание штриховых кодов.

Нефтяная и химическая промышленность:

анализ геологической информации;

идентификация неисправностей оборудования;

разведка залежей минералов по данным аэрофотосъемок;

анализ составов примесей;

управление процессами.

Военная промышленность и аэронавтика:

обработка звуковых сигналов (разделение, идентификация, локализация);

обработка радарных сигналов (распознавание целей, идентификация и локализация источников);

обработка инфракрасных сигналов (локализация);

обобщение информации;

автоматическое пилотирование.

Промышленное производство:

управление манипуляторами;

управление качеством;

управление процессами;

обнаружение неисправностей;

адаптивная робототехника;

Служба безопасности:

Биомедицинская промышленность:

анализ рентгенограмм;

обнаружение отклонений в ЭКГ.

Телевидение и связь :

адаптивное управление сетью связи;

сжатие и восстановление изображения.

Многослойный персептрон. Структура. Принцип работы.

Рассмотрим иерархическую сетевую структуру, в которой связанные между собой нейроны (узлы сети) объединены в несколько слоев (Рис. 6.1). На возможность построения таких архитектур указал еще Ф.Розенблатт, однако им не была решена проблема обучения. Межнейронные синаптические связи сети устроены таким образом, что каждый нейрон на данном уровне иерархии принимает и обрабатывает сигналы от каждого нейрона более низкого уровня. Таким образом, в данной сети имеется выделенное направление распостранения нейроимпульсов - от входного слоя через один (или несколько) скрытых слоев к выходному слою нейронов. Нейросеть такой топологии мы будем называть обобщенным многослойным персептроном или, если это не будет вызывать недоразумений, просто персептроном.

Рис.6.1. Структура многослойного персептрона с пятью входами, тремя нейронами в скрытом слое, и одним нейроном выходного слоя.

Персептрон представляет собой сеть, состоящую из нескольких последовательно соединенных слоев формальных нейронов МакКаллока и Питтса. На низшем уровне иерархии находится входной слой, состоящий из сенсорных элементов, задачей которого является только прием и распространение по сети входной информации. Далее имеются один или, реже, несколько скрытых слоев. Каждый нейрон на скрытом слое имеет несколько входов, соединенных с выходами нейронов предыдущего слоя или непосредственно со входными сенсорами X1..Xn, и один выход. Нейрон характеризуется уникальным вектором весовых коэффициентов w. Веса всех нейронов слоя формируют матрицу, которую мы будем обозначать V или W. Функция нейрона состоит в вычислении взвешенной суммы его входов с дальнейшим нелинейным преобразованием ее в выходной сигнал:

(6.1)

(6.1)

Выходы нейронов последнего, выходного , слоя описывают результат классификации Y=Y(X). Особенности работы персептрона состоят в следующем. Каждый нейрон суммирует поступающие к нему сигналы от нейронов предыдущего уровня иерархии с весами, определяемыми состояниями синапсов, и формирует ответный сигнал (переходит в возбужденное состояние), если полученная сумма выше порогового значения. Персептрон переводит входной образ, определяющий степени возбуждения нейронов самого нижнего уровня иерахии, в выходной образ, определяемый нейронами самого верхнего уровня. Число последних, обычно, сравнительно невелико. Состояние возбуждения нейрона на верхнем уровне говорит о принадлежности входного образа к той или иной категории.

Традиционно рассматривается аналоговая логика, при которой допустимые состояния синаптических связей определяются произвольными действительными числами, а степени активности нейронов - действительными числами между 0 и 1. Иногда исследуются также модели с дискретной арифметикой, в которой синапс характеризуется двумя булевыми переменными: активностью (0 или 1) и полярностью (-1 или +1), что соответствует трехзначной логике. Состояния нейронов могут при этом описываться одной булевой переменной. Данный дискретный подход делает конфигурационное пространство состояний нейронной сети конечным (не говоря уже о преимуществах при аппаратной реализации).

Здесь будет в основном описываться классический вариант многослойной сети с аналоговыми синапсами и сигмоидальной передаточной функцией нейронов, определяемой формулой (6.1).

Задача обучения нейронной сети на примерах.

По своей организации и функц. назначению иск. нейронная сеть с неск. входами и выходами выполняет некоторое преобразование входных стимулов - сенсорной информации о внешнем мире - в выходные управляющие сигналы. Число преобразуемых стимулов равно n - числу входов сети, а число выходных сигналов соответствуе числу выходов m. Совокупность всевозможных входных векторов размерности n образует векторное пространство X , которое мы будем называть признаковым пространством (При рассмотрении соответсвующих пространств предполагается использование обычных векторных операций сложения и умножения на скаляр (подробнее см. Лекцию 2 ). Аналогично, выходные вектора также формируют признаковое пространство, которое будет обозначаться Y . Теперь нейронную сеть можно мыслить, как некоторую многомерную функцию F: X Y , аргумент которой принадлежит признаковому пространству входов, а значение - выходному признаковому пространству.

При произвольном значении синаптических весовых коэффициентов нейронов сети функция, реализуемая сетью также произвольна. Для получения требуемой функции необходим специфический выбор весов. Упорядоченная совокупность всех весовых коэффициентов всех нейронов может быть представлена, как вектор W. Множество всех таких векторов также формирует векторное пространство, называемое пространством состояний или конфигурационным (фазовым) пространством W . Термин "фазовое пространство" пришел из статистической физики систем многих частиц, где под ним понимается совокупность координат и импульсов всех частиц, составляющих систему.

Задание вектора в конфигурационном пространстве полностью определяет все синаптические веса и, тем самым, состояние сети. Состояние, при котором нейронная сеть выполняет требуемую функцию, называют обученным состоянием сети W * . Отметим, что для заданной функции обученное состояние может не существовать или быть не единственным. Задача обучения теперь формально эквивалентна построению процесса перехода в конфигурационном пространстве от некоторого произвольного состояния W 0 к обученному состоянию.

Требуемая функция однозначнно описывается путем задания соотвествия каждому вектору признакового пространства X некоторого вектора из пространства Y . В случае сети из одного нейрона в задаче детектирования границы, рассмотренной в конце третьей Лекции , полное описание требуемой функции достигается заданием всего четырех пар векторов. Однако в общем случае, как например, при работе с видеоизображением, признаковые пространства могут иметь высокую размерность, поэтому даже в случае булевых векторов однозначное определение функции становится весьма громоздким (при условии, конечно, если функция не задана явно, например, формулой; однако для явно заданных функций обычно не возникает потребности представления их нейросетевыми моделями). Во многих практических случаях значения требуемых функций для заданных значений аргумента получаются из эксперимента или наблюдений, и, следовательно, известны лишь для ограниченной совокупности векторов. Кроме того, известные значения функции могут содержать погрешности, а отдельные данные могут даже частично противоречить друг другу. По этим причинам перед нейронной сетью обычно ставится задача приближенного представления функции по имеющимся примерам . Имеющиеся в распоряжении исследователя примеры соответствий между векторами, либо специально отобранные из всех примеров наиболее представительные данные называют обучающей выборкой . Обучающая выборка определяется обычно заданием пар векторов, причем в каждой паре один вектор соотвествует стимулу, а второй - требуемой реакции. Обучение нейронной сети состоит в приведении всех векторов стимулов из обучающей выборки требуемым реакциям путем выбора весовых коэффициентов нейронов.

Общая проблема кибернетики, заключающаяся в построении искусственной системы с заданным функциональным поведением, в контексте нейроных сетей понимается, как задача синтеза требуемой искусственной сети. Она может включать в себя следующие подзадачи: 1) выбор существенных для решаемой задачи признаков и формирование признаковых пространств; 2) выбор или разработка архитектуры нейронной сети, адекватной решаемой задаче; 3) получение обучаюшей выборки из наиболее представительных, по мнению эксперта, векторов признаковых пространств; 4) обучение нейронной сети на обучающей выборке.

Отметим, что подзадачи 1)-3) во многом требуют экспертного опыта работы с нейронными сетями, и здесь нет исчерпывающих формальных рекомендаций. Эти вопросы рассматриваются на протяжении всей книги в применении к различным нейросетевым архитектурам, с иллюстрациями особенностей их обучения и применения.

Обучение нейронной сети с учителем как задача многофакторной оптимизации.

Схема искусственного нейрона

1.Нейроны, выходные сигналы которых поступают на вход данному

2.Сумматор входных сигналов

3.Вычислитель передаточной функции

4.Нейроны, на входы которых подаётся выходной сигнал данного

5. - веса

входных сигналов

Иску́сственный нейро́н (математический нейрон Маккалока - Питтса , формальный нейрон Л. Г. Комарцова, А. В. Максимов «Нейрокомпьютеры», МГТУ им. Н. Э. Баумана, 2004 г., ISBN 5-7038-2554-7 ) - узел искусственной нейронной сети , являющийся упрощённой моделью естественного нейрона . Математически, искусственный нейрон обычно представляют как некоторую нелинейную функцию от единственного аргумента - линейной комбинации всех входных сигналов. Данную функцию называют функцией активации По аналогии с нейронами активации или функцией срабатывания , передаточной функцией . Полученный результат посылается на единственный выход. Такие искусственные нейроны объединяют в сети - соединяют выходы одних нейронов с входами других. Искусственные нейроны и сети являются основными элементами идеального нейрокомпьютера .Миркес Е. М. , Нейрокомпьютер. Проект стандарта. - Новосибирск: Наука, 1999. - 337 с. ISBN 5-02-031409-9

Биологический прототип

.Здесь - расстояние между центром и вектором входных сигналов . Скалярный параметр определяет скорость спадания функции при удалении вектора от центра и называется шириной окна , параметр определяет сдвиг активационной функции по оси абсцисс. Сети с нейронами, использующими такие функции, называются RBF-сетями . В качестве расстояния между векторами могут быть использованы различные метрикиВ. В. Круглов, В. В. Борисов - Искусственные нейронные сети. Теория и практика - с.349, обычно используется евклидово расстояние:

.

Здесь - -я компонента вектора, поданного на вход нейрона, а - -я компонента вектора, определяющего положение центра передаточной функции. Соответственно, сети с такими нейронами называются вероятностными и регрессионными В. В. Круглов, В. В. Борисов - Искусственные нейронные сети. Теория и практика - с.348.

В реальных сетях активационная функция этих нейронов может отражать распределение вероятности какой-либо случайной величины , либо обозначать какие-либо эвристические зависимости между величинами.

См. также: {{#if: Сеть радиально-базисных функций | [[Сеть радиально-базисных функций{{#if: | Шаблон:! {{{l1}}} }}]] }} {{#if: Сеть радиально-базисных функций || Ошибка: . }}{{#if: | …Ошибка: . }}{{#if: | {{#if: Сеть радиально-базисных функций | {{#if: || . }} }} }}

Другие функции передачи

Перечисленные выше функции составляют лишь часть от множества передаточных функций, используемых на данный момент. В число других передаточных функций входят такие какText:

- Экспонента ;

- Модульная: ;

Стохастический нейрон

Выше описана модель детерминистического искусственного нейрона, то есть состояние на выходе нейрона однозначно определено результатом работы сумматора входных сигналов. Рассматривают также стохастические нейроны, где переключение нейрона происходит с вероятностью, зависящей от индуцированного локального поля, то есть передаточная функция определена как:

,

где распределение вероятности обычно имеет вид сигмоида:

,

a нормировочная константа вводится для условия нормализации распределения вероятности . Таким образом, нейрон активируется с вероятностью . Параметр - аналог температуры (но не температуры нейрона) и определяет беспорядок в нейронной сети. Если устремить к 0, стохастический нейрон перейдет в обычный нейрон с передаточной функцией Хевисайда (пороговой функцией).

Моделирование формальных логических функций

Нейрон с пороговой передаточной функцией может моделировать различные логические функции. Изображения иллюстрируют, каким образом можно, задав веса входных сигналов и порог чувствительности, заставить нейрон выполнять конъюнкцию (логическое «И») и дизъюнкцию (логическое «ИЛИ») над входными сигналами, а также логическое отрицание входного сигнала. Этих трех операций достаточно, чтобы смоделировать абсолютно любую логическую функцию любого числа аргументов.

См. также

Примечания

Неизвестный тег расширения «references»

Литература

- {{#if:Терехов В.А., Ефимов Д.В., Тюкин И.Ю.|{{#ifeq:{{#invoke:String|sub|Терехов В.А., Ефимов Д.В., Тюкин И.Ю.|-1}}| |Терехов В.А., Ефимов Д.В., Тюкин И.Ю.|{{#ifeq:{{#invoke:String|sub|Терехов В.А., Ефимов Д.В., Тюкин И.Ю.|-6|-2}}| |Терехов В.А., Ефимов Д.В., Тюкин И.Ю.|{{#ifeq:{{#invoke:String|sub|Терехов В.А., Ефимов Д.В., Тюкин И.Ю.|-6|-2}}|/span|Шаблон:±. |Шаблон:±. }}}}}} }}{{#if: |{{#if: |[{{{ссылка часть}}} {{{часть}}}]| {{{часть}}}}} // }}{{#if:|[[:s:{{{викитека}}}|Нейросетевые системы управления]]|{{#if: |Нейросетевые системы управления |{{#if:|[ Нейросетевые системы управления]|Нейросетевые системы управления}}}}}}{{#if:| = }}{{#if:| / {{{ответственный}}}.|{{#if:||.}}}}{{#if:Нейросетевые системы управления|{{#if:| {{#if:| = {{{оригинал2}}} }}{{#if:| / {{{ответственный2}}}.|{{#if:||.}}}}}}}}{{#if:1-е| - 1-е.}}{{#switch:{{#if:|м}}{{#if:Высшая школа |и}}{{#if:2002|г}}

}}{{#if:| - {{{том как есть}}}.}}{{#if:|{{#if: | [{{{ссылка том}}} - Т. {{{том}}}.]| - Т. {{{том}}}.}}}}{{#if:| - Vol. {{{volume}}}.}}{{#if:| - Bd. {{{band}}}.}}{{#if:| - {{{страницы как есть}}}.}}{{#if:184| - С. {{#if:| (стб. {{{столбцы}}}).|184.}}}}{{#if:| - {{{страниц как есть}}}.}}{{#if:| - {{{страниц}}} с.}}{{#if:| - P. {{#if:|[{{{pages}}}] (col. {{{columns}}}).|{{{pages}}}.}}}}{{#if:| - S. {{#if:|[{{{seite}}}] (Kol. {{{kolonnen}}}).|{{{seite}}}.}}}}{{#if:| - p.}}{{#if:| - S.}}{{#if:| - ({{{серия}}}).}}{{#if:| - {{{тираж}}} экз. }}{{#if:5-06-004094-1| - ISBN 5-06-004094-1 DOI :{{{doi}}} {{#ifeq:Шаблон:Str left |10.|| [Ошибка: Неверный DOI! ] {{#if:||}}}}}}

- {{#if:Круглов В. В., Борисов В. В.|{{#ifeq:{{#invoke:String|sub|Круглов В. В., Борисов В. В.|-1}}| |Круглов В. В., Борисов В. В.|{{#ifeq:{{#invoke:String|sub|Круглов В. В., Борисов В. В.|-6|-2}}| |Круглов В. В., Борисов В. В.|{{#ifeq:{{#invoke:String|sub|Круглов В. В., Борисов В. В.|-6|-2}}|/span|Шаблон:±. |Шаблон:±. }}}}}} }}{{#if: |{{#if: |[{{{ссылка часть}}} {{{часть}}}]| {{{часть}}}}} // }}{{#if:|[[:s:{{{викитека}}}|Искусственные нейронные сети. Теория и практика]]|{{#if: |Искусственные нейронные сети. Теория и практика |{{#if:|[ Искусственные нейронные сети. Теория и практика]|Искусственные нейронные сети. Теория и практика}}}}}}{{#if:| = }}{{#if:| / {{{ответственный}}}.|{{#if:||.}}}}{{#if:Искусственные нейронные сети. Теория и практика|{{#if:| {{#if:| = {{{оригинал2}}} }}{{#if:| / {{{ответственный2}}}.|{{#if:||.}}}}}}}}{{#if:1-е| - 1-е.}}{{#switch:{{#if:М.|м}}{{#if:Горячая линия - Телеком|и}}{{#if:2001|г}}

}}{{#if:| - {{{том как есть}}}.}}{{#if:|{{#if: | [{{{ссылка том}}} - Т. {{{том}}}.]| - Т. {{{том}}}.}}}}{{#if:| - Vol. {{{volume}}}.}}{{#if:| - Bd. {{{band}}}.}}{{#if:| - {{{страницы как есть}}}.}}{{#if:382| - С. {{#if:| (стб. {{{столбцы}}}).|382.}}}}{{#if:| - {{{страниц как есть}}}.}}{{#if:| - {{{страниц}}} с.}}{{#if:| - P. {{#if:|[{{{pages}}}] (col. {{{columns}}}).|{{{pages}}}.}}}}{{#if:| - S. {{#if:|[{{{seite}}}] (Kol. {{{kolonnen}}}).|{{{seite}}}.}}}}{{#if:| - p.}}{{#if:| - S.}}{{#if:| - ({{{серия}}}).}}{{#if:| - {{{тираж}}} экз. }}{{#if:5-93517-031-0| - ISBN 5-93517-031-0 .}}{{#if:| - ISBN {{{isbn2}}}.}}{{#if:| - ISBN {{{isbn3}}}.}}{{#if:| - ISBN {{{isbn4}}}.}}{{#if:| - ISBN {{{isbn5}}}.}}{{#if:| - DOI :{{{doi}}} {{#ifeq:Шаблон:Str left |10.|| [Ошибка: Неверный DOI! ] {{#if:||}}}}}}

- {{#if:Каллан Р.|{{#ifeq:{{#invoke:String|sub|Каллан Р.|-1}}| |Каллан Р.|{{#ifeq:{{#invoke:String|sub|Каллан Р.|-6|-2}}| |Каллан Р.|{{#ifeq:{{#invoke:String|sub|Каллан Р.|-6|-2}}|/span|Шаблон:±. |Шаблон:±. }}}}}} }}{{#if: |{{#if: |[{{{ссылка часть}}} {{{часть}}}]| {{{часть}}}}} // }}{{#if:|[[:s:{{{викитека}}}|Основные концепции нейронных сетей]]|{{#if: |Основные концепции нейронных сетей |{{#if:|[ Основные концепции нейронных сетей]|Основные концепции нейронных сетей}}}}}}{{#if:The Essence of Neural Networks First Edition| = The Essence of Neural Networks First Edition }}{{#if:| / {{{ответственный}}}.|{{#if:||.}}}}{{#if:Основные концепции нейронных сетей|{{#if:| {{#if:| = {{{оригинал2}}} }}{{#if:| / {{{ответственный2}}}.|{{#if:||.}}}}}}}}{{#if:1-е| - 1-е.}}{{#switch:{{#if:|м}}{{#if:«Вильямс» |и}}{{#if:2001|г}}

}}{{#if:| - {{{том как есть}}}.}}{{#if:|{{#if: | [{{{ссылка том}}} - Т. {{{том}}}.]| - Т. {{{том}}}.}}}}{{#if:| - Vol. {{{volume}}}.}}{{#if:| - Bd. {{{band}}}.}}{{#if:| - {{{страницы как есть}}}.}}{{#if:288| - С. {{#if:| (стб. {{{столбцы}}}).|288.}}}}{{#if:| - {{{страниц как есть}}}.}}{{#if:| - {{{страниц}}} с.}}{{#if:| - P. {{#if:|[{{{pages}}}] (col. {{{columns}}}).|{{{pages}}}.}}}}{{#if:| - S. {{#if:|[{{{seite}}}] (Kol. {{{kolonnen}}}).|{{{seite}}}.}}}}{{#if:| - p.}}{{#if:| - S.}}{{#if:| - ({{{серия}}}).}}{{#if:| - {{{тираж}}} экз. }}{{#if:5-8459-0210-X| - ISBN 5-8459-0210-X .}}{{#if:| - ISBN {{{isbn2}}}.}}{{#if:| - ISBN {{{isbn3}}}.}}{{#if:| - ISBN {{{isbn4}}}.}}{{#if:| - ISBN {{{isbn5}}}.}}{{#if:| - DOI :{{{doi}}} {{#ifeq:Шаблон:Str left |10.|| [Ошибка: Неверный DOI! ] {{#if:||}}}}}}

- {{#if:Ясницкий Л. Н.|{{#ifeq:{{#invoke:String|sub|Ясницкий Л. Н.|-1}}| |Ясницкий Л. Н.|{{#ifeq:{{#invoke:String|sub|Ясницкий Л. Н.|-6|-2}}| |Ясницкий Л. Н.|{{#ifeq:{{#invoke:String|sub|Ясницкий Л. Н.|-6|-2}}|/span|Шаблон:±. |Шаблон:±. }}}}}} }}{{#if: |{{#if: |[{{{ссылка часть}}} {{{часть}}}]| {{{часть}}}}} // }}{{#if:|[[:s:{{{викитека}}}|Введение в искусственный интеллект]]|{{#if: |Введение в искусственный интеллект |{{#if:|[ Введение в искусственный интеллект]|Введение в искусственный интеллект}}}}}}{{#if:| = }}{{#if:| / {{{ответственный}}}.|{{#if:||.}}}}{{#if:Введение в искусственный интеллект|{{#if:| {{#if:| = {{{оригинал2}}} }}{{#if:| / {{{ответственный2}}}.|{{#if:||.}}}}}}}}{{#if:1-е| - 1-е.}}{{#switch:{{#if:|м}}{{#if:Издательский центр «Академия»|и}}{{#if:2005|г}}

}}{{#if:| - {{{том как есть}}}.}}{{#if:|{{#if: | [{{{ссылка том}}} - Т. {{{том}}}.]| - Т. {{{том}}}.}}}}{{#if:| - Vol. {{{volume}}}.}}{{#if:| - Bd. {{{band}}}.}}{{#if:| - {{{страницы как есть}}}.}}{{#if:176| - С. {{#if:| (стб. {{{столбцы}}}).|176.}}}}{{#if:| - {{{страниц как есть}}}.}}{{#if:| - {{{страниц}}} с.}}{{#if:| - P. {{#if:|[{{{pages}}}] (col. {{{columns}}}).|{{{pages}}}.}}}}{{#if:| - S. {{#if:|[{{{seite}}}] (Kol. {{{kolonnen}}}).|{{{seite}}}.}}}}{{#if:| - p.}}{{#if:| - S.}}{{#if:| - ({{{серия}}}).}}{{#if:| - {{{тираж}}} экз. }}{{#if:5-7695-1958-4| - ISBN 5-7695-1958-4 .}}{{#if:| - ISBN {{{isbn2}}}.}}{{#if:| - ISBN {{{isbn3}}}.}}{{#if:| - ISBN {{{isbn4}}}.}}{{#if:| - ISBN {{{isbn5}}}.}}{{#if:| - DOI :{{{doi}}} {{#ifeq:Шаблон:Str left |10.|| [Ошибка: Неверный DOI! ] {{#if:||}}}}}}

- {{#if:Комарцова Л. Г., Максимов А. В.|{{#ifeq:{{#invoke:String|sub|Комарцова Л. Г., Максимов А. В.|-1}}| |Комарцова Л. Г., Максимов А. В.|{{#ifeq:{{#invoke:String|sub|Комарцова Л. Г., Максимов А. В.|-6|-2}}| |Комарцова Л. Г., Максимов А. В.|{{#ifeq:{{#invoke:String|sub|Комарцова Л. Г., Максимов А. В.|-6|-2}}|/span|Шаблон:±. |Шаблон:±. }}}}}} }}{{#if: |{{#if: |[{{{ссылка часть}}} {{{часть}}}]| {{{часть}}}}} // }}{{#if:|[[:s:{{{викитека}}}|Нейрокомпьютеры]]|{{#if: |Нейрокомпьютеры |{{#if:http://www.books.ru/shop/search/advanced?as%5Bisbn%5D=5703819083&as%5Bsub%5D=%E8%F1%EA%E0%F2%FC%7C Нейрокомпьютеры |Нейрокомпьютеры}}}}}}{{#if:| = }}{{#if:| / {{{ответственный}}}.|{{#if:||.}}}}{{#if:Нейрокомпьютеры|{{#if:| {{#if:| = {{{оригинал2}}} }}{{#if:| / {{{ответственный2}}}.|{{#if:||.}}}}}}}}{{#if:1-е| - 1-е.}}{{#switch:{{#if:|м}}{{#if:Изд-во МГТУ им. Н.Э. Баумана|и}}{{#if:2002|г}}